在全球人工智能浪潮中,中国正积极推动构建安全、可靠、可控的“可信人工智能”体系。这一“中国方案”不仅关乎技术发展,更强调以人为本、科技向善的治理理念。可信AI系统并非单一技术突破的产物,而是由一系列支撑技术构成的复杂生态系统,这些技术共同为人工智能应用的软件开发奠定了坚实基础。

一、构建可信AI系统所需的关键支撑技术

- 数据安全与隐私计算技术:这是可信AI的基石。包括:

- 联邦学习:允许多方在数据不离开本地的情况下协同训练模型,实现“数据可用不可见”。

- 差分隐私:通过在数据或模型参数中添加精心设计的噪声,保护个体信息不被泄露。

- 同态加密与安全多方计算:允许对加密数据进行直接计算,确保数据处理全流程的机密性。

- 数据脱敏与匿名化:从源头减少敏感信息暴露风险。

- 算法可解释性与鲁棒性技术:

- 可解释AI(XAI):通过可视化、特征重要性分析、自然语言解释等方法,使“黑箱”模型的决策过程对开发者、监管者和用户透明。

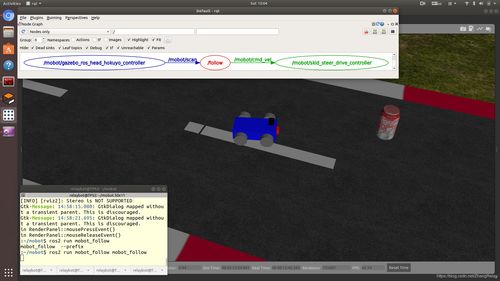

- 对抗性鲁棒性:增强模型抵御恶意输入(对抗样本)的能力,确保其在复杂、对抗环境下的稳定性和可靠性。

- 公平性检测与消偏算法:识别并修正训练数据或算法中可能存在的偏见,确保决策公正,不歧视任何群体。

- 系统可靠与可控技术:

- 持续监测与验证:在模型部署后,持续监控其性能、行为和数据分布变化,及时发现并纠正模型漂移或异常。

- 失效安全与回滚机制:当AI系统出现不可预测的故障或有害输出时,能自动或手动触发安全机制,切换到安全状态或可信任的旧版本。

- 形式化验证:运用数学方法严格证明系统在特定条件下的行为符合预设的安全规范。

- 治理与合规支撑技术:

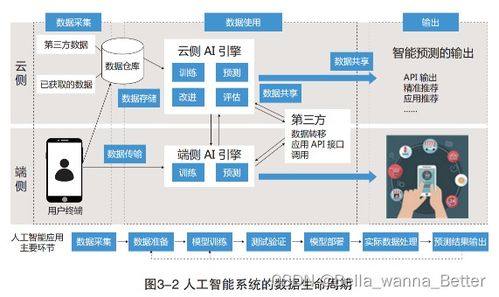

- AI审计与溯源技术:记录模型开发、训练、部署的全生命周期数据,实现全过程可追溯、可审计。

- 合规性自动检查工具:帮助开发者和企业自动检测AI系统是否符合相关法律法规和标准(如中国的《生成式人工智能服务管理暂行办法》)。

二、面向可信AI的应用软件开发实践

在可信AI的“中国方案”指引下,应用软件的开发流程需深度融合上述支撑技术,并体现以下特点:

- “可信内嵌”的开发范式:可信属性不再是事后附加,而是在软件需求分析、架构设计、编码、测试、部署、运维的全生命周期中优先考虑和内置。开发团队需要建立“安全左移”和“可信设计”的文化。

- 模块化与标准化的可信组件库:开发基于中国标准(如《人工智能 可信赖 第1部分:总体框架》等系列国标)的可信AI软件工具包、开发框架和中间件。例如,集成隐私计算算子、可解释性分析模块、公平性评估插件的SDK,降低开发者的技术门槛。

- 人机协同与交互设计:软件设计需强调人的监督与控制权。例如,在关键决策环节设置“人在回路”机制,提供清晰的可解释界面,让用户理解AI的建议并保留最终决定权。

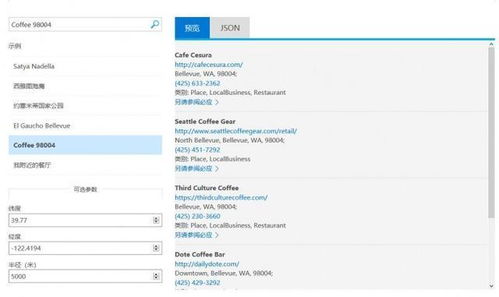

- 场景驱动的可信需求细化:不同应用场景(如金融风控、医疗诊断、自动驾驶、内容生成)对可信维度的要求侧重点不同。开发过程需首先明确具体场景下的核心可信指标(如医疗AI的可解释性要求极高,金融AI则强调公平性与审计溯源),并据此进行技术选型和设计。

- 持续运维与动态评估:可信AI软件开发并非以部署上线为终点。需建立持续的模型性能与行为监控体系,利用支撑技术动态评估其可信度,并建立快速迭代和更新的流程。

###

构建可信AI的“中国方案”,是一个融合技术创新、标准制定、伦理规范和产业实践的系统工程。其核心支撑技术为打造可靠、透明、公平、安全的人工智能提供了工具集。而将这些技术有效、系统地融入人工智能应用软件的开发全流程,则是将“可信”理念落地的关键。随着技术的不断成熟和生态的完善,以可信为基石的中国AI应用,将在赋能千行百业的更好地守护安全、增进福祉,引领全球人工智能治理的新方向。